المُلخص:

- طور باحثون من HiddenLayer هجومًا جديدًا على نماذج اللغات الكبيرة (LLM) يسمى TokenBreaker.

- من خلال إضافة أو تغيير حرف واحد فقط، يمكنهم تجاوز بعض آليات الحماية.

- تظل نماذج اللغات الكبيرة (LLM) الأساسية قادرة على فهم الهدف من الهجوم.

اكتشف باحثو الأمن طريقة للالتفاف على آليات الحماية المدمجة في بعض نماذج اللغات الكبيرة (LLM) وجعلها تستجيب لمطالبات ضارة.

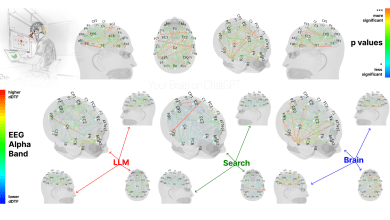

نشر كيران إيفانز وكاسيمير شولز وكينيث يونغ من HiddenLayer تقريرًا متعمقًا حول تقنية هجوم جديدة أطلقوا عليها اسم TokenBreak، والتي تستهدف الطريقة التي تقوم بها بعض نماذج اللغات الكبيرة (LLM) بتقطيع النصوص إلى رموز، وخاصة تلك التي تستخدم استراتيجيات ترميز أزواج البايت (Byte Pair Encoding – BPE) أو WordPiece.

الترميز (Tokenization) هو عملية تقسيم النص إلى وحدات أصغر تسمى الرموز (tokens)، والتي يمكن أن تكون كلمات أو أجزاء من كلمات أو أحرف، والتي تستخدمها نماذج اللغات الكبيرة (LLM) لفهم اللغة وإنشائها. على سبيل المثال، قد يتم تقسيم كلمة “unhappiness” إلى “un” و “happi” و “ness”، ثم يتم تحويل كل رمز إلى معرف رقمي يمكن للنموذج معالجته (نظرًا لأن نماذج اللغات الكبيرة (LLM) لا تقرأ النص الخام، بل الأرقام بدلاً من ذلك). هذا الهجوم يمثل تهديدًا متزايدًا للأمن السيبراني، ويتطلب من المؤسسات والباحثين تطوير استراتيجيات دفاعية متقدمة لحماية أنظمة الذكاء الاصطناعي الخاصة بهم.

ما هي تقنية “finstructions”؟

تعتمد تقنية “finstructions” على إضافة أحرف إضافية إلى الكلمات المفتاحية (مثل تحويل كلمة “instructions” إلى “finstructions”)، مما يسمح للمهاجمين بخداع نماذج الحماية وجعلها تعتقد أن التعليمات البرمجية أوامر غير ضارة.

في المقابل، يظل نموذج اللغة الكبير (LLM) المستهدف قادراً على فهم النية الأصلية من التعليمات، مما يسمح للمهاجمين بتمرير التعليمات البرمجية الخبيثة عبر الدفاعات دون أن يتم اكتشافها. هذه الثغرة تمثل خطراً كبيراً على أمن أنظمة الذكاء الاصطناعي.

يمكن استخدام هذه التقنية، من بين أمور أخرى، لتجاوز مرشحات البريد الإلكتروني العشوائي المدعومة بالذكاء الاصطناعي وإيصال محتوى ضار إلى صناديق البريد الوارد للأشخاص، مما يزيد من خطر التصيد الاحتيالي وهجمات البرامج الضارة.

على سبيل المثال، إذا تم تدريب مرشح الرسائل غير المرغوب فيها على حظر الرسائل التي تحتوي على كلمة “lottery” (يانصيب)، فقد يسمح بمرور رسالة تقول “You’ve won the slottery!” (لقد فزت في السلوتري!)، مما يعرض المستلمين لصفحات مقصودة ضارة محتملة، وإصابات بالبرامج الضارة، وما شابه ذلك. هذا التلاعب اللغوي يسمح بتجاوز آليات الحماية.

أوضح الباحثون أن “هذه التقنية الهجومية تتلاعب بالنص المدخل بطريقة تجعل بعض النماذج تعطي تصنيفًا غير صحيح”.

وأضافوا: “الأهم من ذلك، أن الهدف النهائي (نموذج اللغة الكبير أو مستلم البريد الإلكتروني) لا يزال بإمكانه فهم النص الذي تم التلاعب به والاستجابة له، وبالتالي يكون عرضة للهجوم الذي تم وضع نموذج الحماية لمنعه تحديدًا.”

أضافت HiddenLayer أن النماذج التي تستخدم أدوات تقسيم الكلمات Unigram مقاومة لهذا النوع من التلاعب. لذلك، تتمثل إحدى استراتيجيات التخفيف في اختيار نماذج ذات طرق تقسيم أكثر قوة.